我们曾为“猜你喜欢”的精准而惊叹,为APP预判需求而感慨技术的贴心。但今天,大数据与人工智能的融合正将软件开发推向一个更深刻、也更值得警惕的阶段:它不再满足于“懂你”,而是开始系统性地“塑造你”。这不仅是技术的升级,更是一场关于人性、自主与未来社会形态的深刻变革。

一、从“反映”到“建构”:数据驱动开发的范式跃迁

传统大数据应用的核心是“分析-响应”模式:收集用户行为数据,建立模型,预测偏好,进而优化产品或服务。例如,电商推荐商品,资讯平台推送内容。其逻辑基础是“用户已有需求,我来更好满足”。

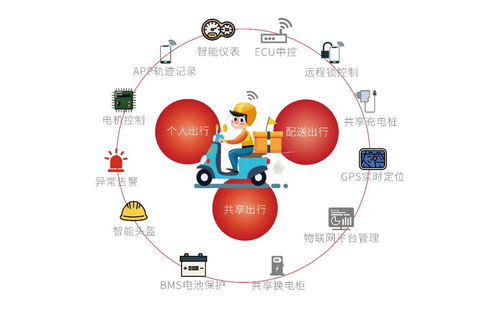

而新一代的智能软件开发,正转向“引导-塑造”模式。通过海量数据与强化学习,系统不仅能预测你的下一个点击,更能通过微妙的交互设计、信息排序、奖励反馈(如点赞、成就系统),潜移默化地影响你的行为轨迹、决策习惯乃至价值观形成。例如:

- 个性化信息茧房的强化建造:算法不只给你看喜欢的,更会持续推荐能引发强烈情绪反应(尤其是焦虑、愤怒或愉悦)的内容,以此延长使用时间,塑造你的认知焦点。

- 行为闭环的精密设计:从健身APP的社交打卡到学习软件的进度激励,软件通过数据反馈不断调整激励策略,旨在将特定行为固化为习惯,使用户“依赖”其设定的路径。

- 预测性干预的先发制人:在健康、金融等领域,软件可能基于预测模型,在你尚未意识到风险时,就主动引导你采取特定行动(如购买保险、调整作息),将“服务”前置为“管理”。

二、“比懂你更可怕”的深层意涵:自主性的侵蚀与伦理困境

当软件的目标从“满足需求”变为“塑造行为”,其“可怕”之处便凸显出来:

- 认知主权的模糊:我们的选择在多大程度上是自由的?当每个选项的出现顺序、呈现方式都由一个以“最大化用户参与/商业目标”为优化的算法所精心安排时,自由意志的边界变得模糊。软件不再只是工具,而成为隐形的“选择架构师”。

- 人性算法的博弈:软件通过A/B测试、多臂老虎机等算法,持续寻找驱动人类行为的最有效刺激点(如社交认可、恐惧、即时满足)。这本质上是一场不对等的博弈——一方是集全球数十亿人行为数据训练的超级系统,另一方是凭直觉行事的个体。长此以往,人的行为模式可能被“驯化”得更加可预测、更符合算法效率。

- 规模化塑造与群体分化:这种塑造能力不是个体层面的,而是规模化的。系统可以为不同群体定制差异化的“塑造路径”,可能加剧社会的信息割裂、观念极化。相同的技术,既可用来培养健康习惯,也可用于放大偏见或推广极端观点。

- 责任归属的真空:如果一个人因长期使用某款APP而形成极端观点或成瘾行为,责任在用户、开发者、算法还是数据?现有的法律与伦理框架难以界定这种新型的、非强制性的“软性影响”所带来的责任。

三、对软件开发者的新挑战:在能力与克制之间

面对这种强大的“塑造力”,负责任的软件开发需要引入新的原则:

- 透明性与可解释性:不应只是算法的“黑箱”。用户应有权利知晓信息排序、推荐的基本逻辑,以及系统试图达成的目标是什么。

- 用户可控与校准:提供更强大的用户控制面板,允许调整算法偏好,甚至选择“不被塑造”的简单模式。系统应提供定期“认知校准”功能,如展示信息图谱,让用户看到自己关注领域的全貌。

- 价值对齐设计:开发之初就必须进行伦理审查,明确软件的核心价值是促进用户的真实福祉与自主性,而非单纯最大化停留时长或商业转化。需要建立“道德刹车”机制。

- 多元化与反脆弱:主动引入打破信息茧房的设计,如随机推荐、对立观点温和展示等,增强系统的包容性和用户的认知弹性。

四、展望:走向人机协同的“增强智能”

未来的出路并非拒绝技术,而是重新定位。大数据与软件开发的终极目标,不应是建造一个完美预测和塑造人的“上帝视角”系统,而是发展一种“增强智能”——即技术用于拓展人的认知边界、增强人的判断能力、保护人的自主性。

例如,软件可以提示用户:“您最近关注的内容情绪化比例较高,建议平衡阅读以下理性分析”;或在用户做出重大决策前,提供更全面的数据视图和不同的分析角度,帮助人做出更明智、更自主的决定。

****

大数据再次变革下的软件开发,正站在一个十字路口。一条路通往一个高度“高效”但可能令人被动、被预设的世界;另一条路则通向一个技术真正赋能于人,尊重并增强人类自主与多样性的未来。选择权,此刻仍掌握在开发者、监管者与每一位用户的手中。比“懂你”更可怕的,或许是我们对此进程的无意识与沉默。唯有清醒的认识、公开的讨论和审慎的设计,才能确保这场变革引领我们走向一个更美好的数字社会。